De heren beginnen hun sessie met een vraag aan het publiek: aan welke use cases werk je, welke uitdagingen kwam je tegen en hoe heb je ze opgelost? Een privacy professional reageert en vertelt dat hij worstelt met de vraag wanneer een algoritme onder de AI-Act valt en in welke risicoklassering? Een vraag die velen in de zaal bezighoudt en die Hoovers beantwoordt via een andere vraag die hij veel krijgt als hij uitleg geeft over de act: ‘Zet AI-wetgeving geen rem op innovatie?’ Hoovers vergelijkt het met de ontwikkeling van de auto door mevrouw Benz. Een vergelijking die bestuursvoorzitter van de AFM, Laura van der Geest, recent ook maakte in een interview met het NRC. Beiden zien een parallel tussen het effect van de auto op de samenleving en het effect van digitalisering, Big Tech en AI op de financiële wereld. Uiteindelijk ging de wereld door dat gemotoriseerde rijtuig, zeker toen deze steeds veiliger werd, niet alleen anders reizen, maar ook anders wonen en zelfs anders eten.

"Zet AI-wetgeving geen rem op innovatie?"

Hoovers: “De AI-Act is zogeheten ‘product safety’-wetgeving: AI-systemen komen alleen op de markt als het gebruik ervan veilig is en dat geeft vertrouwen om het verantwoord te ontwikkelen.” Maar of die vergelijking ook opgaat voor AI-Act, die vraag blijft hangen in de zaal, omdat de verordening onder de aanwezigen juist heel veel vragen oproept. Vooral dus over welke eisen nu precies wanneer van toepassing zijn.

Van input nieuwe output maken

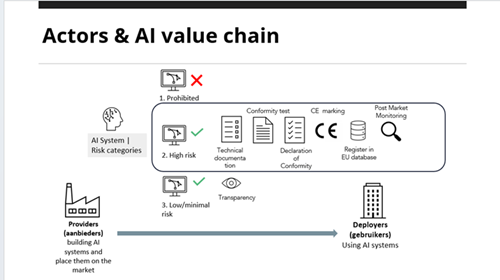

De AI-Act is gebaseerd op AI-systemen die op basis van input, nieuwe output maken. Daar valt dus bijna alles onder. “De definitie is erg ruim,” geeft ook Hoovers toe, “en daarbovenop worden AI-toepassingen ook nog geclassificeerd: van verboden (bijvoorbeeld biometrische toepassingen of gezichtsherkenning) tot hoog en laag risico.”

(Dubbelklik op afbeelding om te vergroten)

Provider of deployer?

Om vast te kunnen stellen welke eisen bij welk systeem (en classificatie horen), moet je volgens Hoovers eerst bepalen wat je bent. Ben je een ontwikkelaar van een AI-systeem (provider) of ben je een gebruiker van een dergelijk systeem (deployer)? Volgens Hoovers is het vooral interessant om vast te stellen wanneer je van de ene rol naar de andere rol overschiet. “Gebruik je een systeem met een vooraf bepaalde toepassing, bijvoorbeeld co-pilot, dan ben je wellicht gebruiker. Maar op het moment dat jij dat systeem implementeert in je processen, bijvoorbeeld voor de ontwikkeling van een verzekering, dan kan je ineens een “provider” worden, stelt Hoovers. “Gebruik je het systeem op een andere manier dan de oorspronkelijke maker het voor ogen had? Dan kan dat betekenen dat je ineens aan alle eisen van provider onder de AI-act moet voldoen. Daarom zijn de gebruikersinstructies van providers zo belangrijk: hoe mag je het product van de provider gebruiken? En al die eisen moet je inbakken in de bedrijfsprocessen.”

Eindeloze lijst eisen

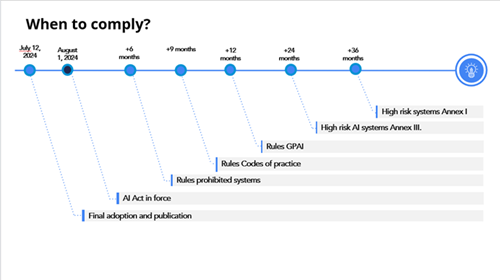

De lijst aan eisen die de AI-Act stelt is lang: eisen aan het ontwikkelen, het toetsen, het documenteren en de ingebruikname ervan. “Alles moet gedocumenteerd worden, ook als je het systeem tussentijds verandert,” waarschuwt Hoovers. “En dan kunnen er aan de categorie van hoog risico systemen ook nog systemen toegevoegd worden. Je dient sommige ontwikkelde AI-systemen te registreren in een toekomstige EU-database en te voorzien van een verplichte CE-certificering,” somt hij op. Gelukkig laat de tijdlijn voor de implementatie van de wet zien dat verzekeraars nog tijd hebben om te bepalen wat je rol is, in welke categorie je AI systeem valt en wanneer je wat geregeld moet hebben.

(Dubbelklik op afbeelding om te vergroten)

Fraudedetectie

Vervolgens is het woord aan Maarten Stolk van Deeploy. Hij gebruikt fraude-opsporing (detectie) als voorbeeld om de regelgeving uit te leggen. Hij stelt dat je met AI goed fraudepatronen kan herkennen. “Machine Learning kan dat veel beter dan mensen.

"AI is goed in fraudepatronen herkennen"

Het aantal foutieve hits kan wel met 85 procent afnemen als je het door AI laat doen, omdat AI modellen miljoenen patronen kan combineren, waar dat bij mensen vaak ophoudt bij enkele verbanden.” Stolk is enthousiast over de toepassing ervan, maar wijst ook op risico’s. “Ben je bijvoorbeeld goed in staat uit te leggen hoe het systeem werkt als bijvoorbeeld een toezichthouder daarom vraagt? Hoe transparant ben je over de toepassing ervan? Is de governance op orde, is de AI-toepassing in lijn met de waarden van de organisatie?” Ook moet een AI-toepassing gaan leven binnen een organisatie. “Bijvoorbeeld door het model uitlegbaar te maken aan gebruikers en ervoor te zorgen dat je de toepassing kan monitoren, alerts kan instellen en de toepassing goed kan documenteren voor compliance en risk. En last but not least: de controle door mensen: klopt het wat het systeem beweerd? Met andere woorden is het ontdekte fraudepatroon ook echt fraude? Zo’n feedback loop is cruciaal om een model bij te sturen, zodat we snel kunnen handelen aan de hand van de uitkomsten.” Op de vraag uit de zaal hoe efficiënt AI-fraudedetectie echt is, ‘want wat je niet weet, spoor je ook niet op’, geeft Stolk aan dat er nog veel fraude doorheen zal glippen, maar door de inzet van modellen is bewezen dat dit aantal wel lager is dan met simpele regels.

Schakel een designer in

Schakel een designer in

Hoe begin je nu met de bouw van je eigen AI-systeem? Een van de opvallende tips die Stolk hierbij kan geven, is om op tijd een designer in te schakelen. “Die zijn in staat om de uitkomst simpel te maken en houden, en ervoor te zorgen dat je gemaakte keuzes kan uitleggen.” Een ander advies is te zorgen voor een feedbackloop voor gebruikers. “Om je modellen te verbeteren en bij te sturen, zodat je geen fouten maakt die bijvoorbeeld mensen kan duperen.”

Na deze uitleg verzucht iemand in de zaal hoe we ervoor gaan zorgen we ons aan alle regels gaan houden? “Als ik het allemaal zelf moet doen, houd ik straks geen tijd meer over voor mijn eigen werk.” In het antwoord zijn Hoovers en Stork eensgezind: daar creëren we een nieuwe functie voor: de chief AI-officer.

Nog meer weten?

Nog meer weten over de AI-Act? Lees dan het interview met Bart Schermer, partner bij Considerati en als hoogleraar Privacy & Cybercrime verbonden aan het eLaw- Centrum voor Recht en Digitale technologie.

Bram Hoovers is Director Legal bij Considerati, een juridisch adviesbureau op gebied van data en technologie. Deeploy is een bedrijf dat een platform aanbiedt om Machine Learning modellen op een verantwoorde en uitlegbare manier in te zetten. Maarten Stolk is CEO en mede-oprichter van dit tech bedrijf, dat in 2023 door Deloitte werd bestempeld als 1 van de 3 meeste innovatieve en disruptieve start-ups in Nederland.